Theo FT, một nhóm gồm nhà nghiên cứu, chuyên gia, học giả hàng đầu về AI và những người có tiếng nói quan trọng trong lĩnh vực này ở Trung Quốc, Mỹ và một số quốc gia khác, đã gặp nhau tại Bắc Kinh cuối tuần qua để bàn về những rủi ro xung quanh AI. Nhóm sau đó ra tuyên bố chung, xác định "ranh giới đỏ" trong việc phát triển trí tuệ nhân tạo, bao gồm chế tạo vũ khí sinh học và tiến hành các cuộc tấn công mạng.

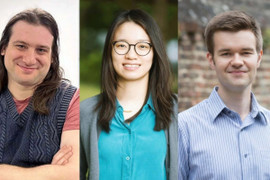

Những người tham gia viết tuyên bố chung có giáo sư Geoffrey Hinton và Yoshua Bengio, được coi là những người tiên phong trong lĩnh vực AI; Stuart Russell, giáo sư khoa học máy tính tại Đại học California, Berkeley; và Andrew Yao, một trong những nhà khoa học máy tính nổi tiếng nhất Trung Quốc. Họ chủ yếu thảo luận mối đe dọa liên quan đến siêu trí tuệ nhân tạo AGI với khả năng bằng hoặc vượt con người.

Nhóm cảnh báo cần có cách tiếp cận chung về an toàn AI nhằm ngăn "những rủi ro thảm khốc hoặc thậm chí hiện hữu đối với nhân loại trong cuộc đời của chúng ta". Trong đó, con người cần chặn các hệ thống AI vượt khuôn khổ, chẳng hạn "không hệ thống AI nào có thể sao chép hoặc cải thiện chính nó mà không có sự chấp thuận và hỗ trợ rõ ràng của con người, cũng như thực hiện các hành động tăng sức mạnh và sức ảnh hưởng một cách quá mức".

Ngoài ra, AI cũng không được can thiệp vào các vấn đề như thiết kế vũ khí hủy diệt hàng loạt, vi phạm công ước quốc tế về vũ khí sinh học hoặc tự động thực hiện cuộc tấn công mạng gây tổn hại nghiêm trọng đến tài chính, quân sự.

Các chuyên gia hàng đầu về trí tuệ nhân tạo nhấn mạnh cảnh báo mới sẽ đặt mục tiêu tương tự nỗ lực tránh xung đột hạt nhân thời Chiến tranh Lạnh. "Sự phối hợp giữa chính phủ và giới khoa học quốc tế đã giúp ngăn chặn thảm họa nhiệt hạch. Nhân loại một lần nữa cần có sự phối hợp tương tự để ngăn chặn thảm họa có thể phát sinh từ công nghệ chưa từng có hiện nay", tuyên bố viết.

"Trọng tâm cốt lõi của cuộc thảo luận là các 'ranh giới đỏ' mà không hệ thống AI mạnh mẽ nào nên vượt qua và các chính phủ cũng nên áp đặt lằn ranh này trong phát triển và triển khai AI", giáo sư Bengio nói.

Trước đó, châu Âu cũng bỏ phiếu tán thành Đạo luật AI (The AI Act) ngày 13/3. Đây được xem là bước cuối trong việc thông qua luật kiểm soát AI, đặt ra quy tắc sâu rộng trong việc ứng dụng công nghệ này, cấm một số hoạt động sử dụng AI nhất định, và yêu cầu đánh giá các hệ thống AI được coi là có rủi ro cao. Liên minh châu Âu dự kiến chính thức thông qua luật vào tháng 5 và sẽ có hiệu lực từ đầu năm tới.

Sự phát triển quá nhanh của AI gây lo ngại lớn. Giữa tháng 3, báo cáo do chính phủ Mỹ ủy quyền đối tác thực hiện cũng cảnh báo AI có thể gây "mối đe dọa với loài người ở cấp độ tuyệt chủng" và cần có ngưỡng kiểm soát.

Tháng 3 năm ngoái, hơn 1.000 người, được xem là giới tinh hoa trong lĩnh vực công nghệ, như tỷ phú Elon Musk, nhà đồng sáng lập Apple Steve Wozniak, đã ký một bức thư kêu gọi các công ty, tổ chức toàn cầu ngừng cuộc đua AI trong sáu tháng để xây dựng một bộ quy tắc chung về công nghệ. Một tháng sau, một thông điệp được ký bởi 350 người, là các lãnh đạo và chuyên gia đầu ngành AI, cũng ra cảnh báo tương tự.